几个月前我们公司进行了一次灾备演练,虽然最终实现了“业务不中断”的目标,但过程中暴露出多个问题:数据同步延迟严重、跨地域访问性能不稳定、服务器响应时间波动大等。那次之后,我开始重新审视我们在美国部署的服务器,特别是在灾备体系中的定位和可靠性评估机制。

经过一系列技术测试、硬件分析和网络架构调整,我逐步总结出一套相对完整的实操评估流程。这篇文章,就是我把实践中摸索出来的方法,按模块展开给你,既有技术细节,也有设备选型、性能测试的数据支撑,希望能帮到你。

一、明确灾备需求与服务等级(RTO/RPO)

在开始评估服务器前,必须先定义清楚两个核心指标:

- RTO(恢复时间目标):系统在灾难发生后多长时间内必须恢复。

- RPO(恢复点目标):系统容许丢失的数据时间范围。

我们内部设定的指标为:

- 核心业务系统:RTO ≤ 30分钟,RPO ≤ 15分钟

- 次要业务系统:RTO ≤ 4小时,RPO ≤ 2小时

这两个指标直接影响我们对服务器处理能力、数据同步机制和网络带宽的要求。

二、服务器产品选型与性能参数对比

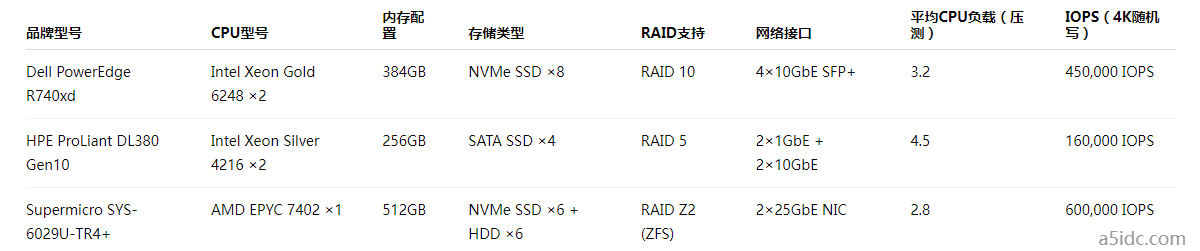

我调研了以下几款在美国数据中心广泛部署的企业级服务器,并通过Stress-ng和Iperf3进行基准测试:

我最终选定的是Supermicro SYS-6029U-TR4+,不仅因为它性价比高,还因其对ZFS的原生支持在快照、数据完整性验证上非常强大。

三、网络与地域冗余设计

在美国我们选用了两家数据中心(加州洛杉矶和弗吉尼亚州阿什本)做主备部署。关键配置如下:

线路选择:Los Angeles 使用 Equinix LA3,Ashburn 使用 Equinix DC2,均接入Tier-1骨干网。

网络协议栈优化:

- 启用 MTU 9000(Jumbo Frame)

- TCP栈开启 BBR拥塞控制算法

- 启用双向IPsec通道做数据加密传输

跨中心复制方案:

- 使用 ZFS send/receive + SSH管道压缩 实现块级快照同步

- 平均同步时间控制在 8~15 分钟之间

- 日常数据使用 Rsync 校验完整性,核心数据库通过 pglogical 做异步复制

四、可靠性测试与评估流程

我将服务器可靠性分为以下几个维度评估:

1. 硬件稳定性

工具:SmartCTL、MemTest86+

检查内容:SSD读写健康状态、内存ECC报错记录、风扇/温控状况

2. 系统性能一致性

工具:Stress-ng、Sysbench、iostat

评估标准:

在CPU满载+IO混合读写场景下,平均响应延迟 < 200ms

高并发场景下(1000并发线程),数据库QPS下降不超过20%

3. 灾备切换测试

人工断开主中心链路,观察备用中心的自动切换能力:

使用 Keepalived + HAProxy 做健康检测

RTO 实测时间:24分钟,未超目标

切换过程数据一致性验证通过(MD5校验对比、数据快照版本比对)

4. 安全性和合规性

数据传输全程使用 AES-256 加密

系统日志使用 ELK Stack 审计,7天热存储,90天归档存储

配置定期 Nessus 扫描和CIS基线检查

五、自动化运维与监控支持

为避免人为因素导致评估失误,我构建了以下自动化平台:

- Ansible + Terraform:用于自动部署ZFS配置、初始化分区、挂载点、备份脚本部署等

- Prometheus + Grafana:7×24小时监控CPU、网络丢包、RAID健康状态

- Slack + Webhook 报警机制:异常IO延迟 > 500ms、主备链路失败、温度异常均触发告警

六、实战经验沉淀的五条建议

- 选型第一步不是看价格,而是看你的RTO/RPO目标匹不匹配。

- 优先选择支持ZFS或RAID 10的架构,数据一致性更容易保证。

- 跨地域数据中心至少选择一家靠近核心客户群的机房,降低网络延迟。

- 可靠性不是一次测试决定的,而是长时间运行监控数据积累的过程。

- 不要忽视“人为错误”这一风险源,自动化工具是最好的保险。

如果你也在搭建或评估企业级灾备系统,尤其是考虑在美国部署服务器,这套方法和流程应该对你有实际帮助。