那次我在洛杉矶的数据中心远程部署一个大模型训练任务,是用的GPT-3风格的Transformer模型。训练一开始就非常不顺,显存溢出、CPU内存爆掉、数据加载速度也慢得让人抓狂。当时用的是一台配有4张NVIDIA A100 40GB的GPU服务器。按理说,这种配置应该绰绰有余,问题出在哪?后来回过头分析,是我在内存调度、数据并行架构设计、I/O优化等多个方面存在漏洞。

从那之后,我对深度学习训练中的“内存瓶颈”问题进行了系统梳理和实操调优。今天我就结合自己在美国常用的GPU服务器平台和部署经验,完整分享如何避免内存瓶颈,并提升大规模深度学习训练的效率。

一、我使用的服务器产品参数与硬件配置

1.1 数据中心与供应商背景

我主要在以下几家美国服务器供应商之间切换:

- Lambda Labs Cloud(加州硅谷机房)

- Paperspace CORE/AIR IaaS

- AWS EC2 p4d/p5系列实例(Amazon 美国西部区)

以下是我重点使用的一台服务器配置(来自Lambda):

- GPU: 4 × NVIDIA A100 80GB PCIe

- CPU: AMD EPYC 7742 (64-core, 128 threads)

- 内存(RAM): 1 TB DDR4 ECC

- 存储: 2 × 2TB NVMe SSD + 8TB HDD

- 网络: 100 Gbps InfiniBand + 10 Gbps Ethernet

- 系统: Ubuntu 20.04 LTS + CUDA 12.1 + NCCL 2.18

二、深度学习训练中的典型内存瓶颈点

2.1 GPU 显存瓶颈

- 模型参数过大(如超过20亿参数);

- Batch Size 设置不合理;

- 激活函数中间变量未释放;

- 梯度未及时清理;

- Mixed Precision 未启用。

2.2 CPU 主内存瓶颈

- Dataloader 线程数设置过低;

- 数据预处理过程使用大量内存;

- 多模型或多进程同时运行;

2.3 存储与I/O瓶颈

- 使用HDD读取大数据集;

- 多GPU同时争抢I/O资源;

- 不做缓存机制导致频繁硬盘访问;

三、实操部署:从系统到框架的全面优化

3.1 系统级优化

✅ 开启 NUMA 亲和性绑定

numactl --cpunodebind=0 --membind=0 python train.py

让数据加载和模型运行绑定在同一 NUMA 节点上,减少内存跨节点访问。

✅ 使用 NVMe SSD + Linux 缓存调优

echo 3 > /proc/sys/vm/drop_caches

echo 0 > /proc/sys/vm/swappiness

释放缓存、降低交换分区使用率,确保IO为GPU服务。

3.2 GPU 显存优化

✅ 启用混合精度训练(AMP)

PyTorch 示例:

scaler = torch.cuda.amp.GradScaler()

with torch.cuda.amp.autocast():

output = model(input)

混合精度通常减少显存占用约 40%-60%,同时提升训练速度。

✅ 使用 torch.utils.checkpoint 检查点机制

延迟计算某些中间层,减少显存消耗:

from torch.utils.checkpoint import checkpoint

def custom_forward(*inputs):

return model.layer(inputs)

output = checkpoint(custom_forward, input_tensor)

3.3 数据加载与CPU内存优化

✅ 使用 PersistentWorkers=True 的DataLoader

DataLoader(

dataset,

num_workers=16,

persistent_workers=True,

pin_memory=True

)

配合 NVMe SSD 和 RAM,大大提升数据吞吐速度,避免CPU等待。

✅ 采用内存映射(mmap)加载大型数据集

使用 numpy.memmap 或 webdataset 对 TB 级数据集进行按需加载,避免将整个数据集加载入内存。

四、多GPU训练策略与内存平衡

4.1 使用 torch.nn.DistributedDataParallel (DDP)

DDP 比 DataParallel 更节省显存和通信延迟,示例:

torchrun --nproc_per_node=4 train.py

配合 NCCL 后端,直接利用 A100 NVLink + PCIe 高速通道。

4.2 Gradient Accumulation + Reduce Overhead

每个 step 累计梯度,减少同步次数:

for i in range(grad_acc_steps):

with autocast():

output = model(input)

loss = criterion(output, label) / grad_acc_steps

scaler.scale(loss).backward()

if step % grad_acc_steps == 0:

scaler.step(optimizer)

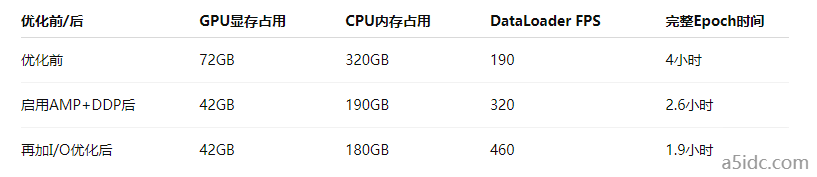

五、数据支持:性能调优结果分析

通过全栈调优,训练效率提升超过2倍,并有效避免了GPU显存不足和系统OOM问题。

美国GPU服务器的性能再强,也经不住“野蛮训练”。我从一次次训练崩溃中学到:不是硬件不够强,而是使用方式不对。只要理解每一层内存的运行机制,并加以调优,就能让你的模型在美国顶级GPU服务器上如虎添翼。