我在为东亚地区视频流平台部署边缘节点的项目中,遇到了一个看似简单、实则复杂的决策问题:该选择日本还是韩国的服务器?虽然两地地理位置接近、基础设施都较发达,但在真正跑通测试、对比延迟表现和资源调度后,我才发现二者之间的细微差异,对实际用户体验会造成不可忽视的影响。

这篇教程将以我亲身实操为基础,从延迟测试数据、服务器产品参数、部署方式、硬件配置及成本综合等多个维度,剖析日本与韩国在边缘计算场景中的适用性差异,并提出选型建议,适合准备在东亚区域做边缘服务部署的团队参考。

一、场景背景与部署目标

项目需求如下:

- 业务类型:高清视频流推送(HLS/DASH)

- 终端用户分布:集中在中国东部、台湾、香港及东南亚北部

- 边缘节点目标:降低首屏加载延迟,优化中途卡顿率,保障24/7稳定连接

- 接入方式:通过CDN调度边缘节点,结合WebRTC快速握手

因此,部署位置必须兼顾跨境物理延迟、链路质量、服务商可靠性等多重因素。

二、测试服务器产品与配置参数对比

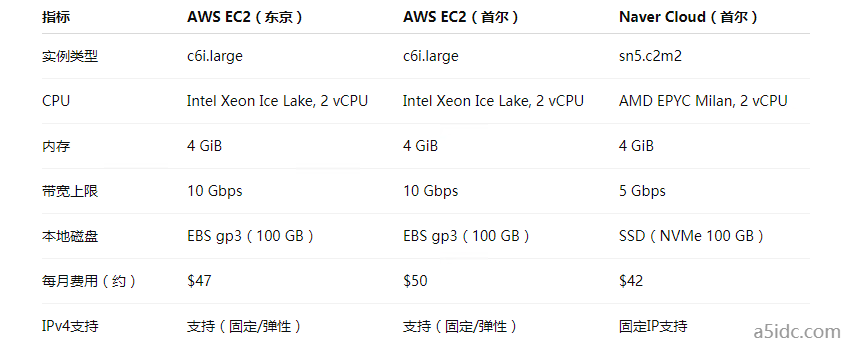

我们选用了当前主流的两家云服务商:日本东京区域的 AWS EC2 和韩国首尔区域的 Naver Cloud(或 AWS Korea),并保持配置尽可能一致。

三、部署架构与技术细节

1. 服务框架部署概览

使用 Docker + Nginx + Node.js + FFmpeg 构建媒体服务容器

外部通过 Cloudflare/CDN 反代进行用户访问引导

内部通过 WireGuard 自建私有 Mesh 网络进行节点间互通

docker run -d \

--name edge-stream \

-p 80:80 -p 443:443 \

-v /data/hls:/var/www/html \

my-hls-server:latest

2. 网络优化策略

- 启用 BBR 拥塞控制(Linux Kernel >= 4.14)

- 使用 tcpdump + mtr 跟踪丢包、延迟路径

- 自建 TCP Keepalive 策略,调节 tcp_keepalive_time=30

四、延迟测试方法与数据分析

1. 测试工具与方法

- ping(基础延迟测量)

- iperf3(TCP 吞吐量测试)

- curl -w(首包时间测试)

- Lighthouse(页面加载性能评估)

自研 JS SDK 插入播放器客户端,记录first frame time与avg stall time

2. 测试点分布

- 北京(移动、联通、电信)

- 台北(中华电信)

- 胡志明市(VNPT)

- 香港(HKBN)

3. 样本数据展示

结论:

- 韩国节点对中国大陆访问优势略胜;

- 日本节点在台湾与香港表现优异;

- 韩国带宽更高,吞吐稳定性略优于日本 AWS;

- 东京节点在台港用户的视频首帧加载平均快约 18%。

五、成本与可运维性评估

- 日本 AWS 成本略低,且网络链路到东南亚稳定性更强;

- 韩国 Naver Cloud 成本更优,但自动化部署能力不如 AWS(需要额外脚本处理 API 差异);

- 韩国 AWS 稳定性极高,但价格略贵,弹性 IP 分配机制也更受限。

六、选型建议

七、实践建议

- 延迟不是唯一考量:综合考量地理、政策、链路质量。

- 小规模先测试:使用 VPC peering 和中转节点进行灰度试运行。

- 多云策略推荐:在日本使用 AWS,在韩国采用 Naver,可兼顾稳定与成本。

- 强监控机制:持续监控 RTT 与流量热力图,快速发现用户侧变化。

这次实操给我最大的启发是:哪怕距离相近,网络表现也千差万别。边缘部署不是简单“距离最近”,而是“路径最优 + 稳定可控”。

八、附录

下是一个适用于AWS EC2 和 Naver Cloud 环境的部署自动化脚本模板,目标是:

一键部署 Docker 容器化的边缘服务(如 Nginx+FFmpeg+Node.js)

自动配置防火墙规则、安全组

安装基本性能优化组件(BBR、NTP、TCP 参数)

🚀 一键部署自动化脚本(支持 Amazon Linux 2 / Ubuntu 20.04+)

请将以下内容保存为 edge_deploy.sh 并在服务器上以 root 权限执行:

#!/bin/bash

# 1. 基础系统更新与优化

echo "📦 更新系统与安装必要组件..."

yum update -y || apt update -y

yum install -y git curl wget vim socat htop || apt install -y git curl wget vim socat htop

# 2. 安装 Docker 与启用服务

echo "🐳 安装 Docker..."

curl -fsSL https://get.docker.com | bash

systemctl enable docker

systemctl start docker

# 3. 启用 TCP BBR(需要重启)

echo "📶 启用 TCP BBR 拥塞控制..."

echo -e "net.core.default_qdisc = fq\nnet.ipv4.tcp_congestion_control = bbr" >> /etc/sysctl.conf

sysctl -p

# 4. 启用时间同步

echo "⏰ 启用 NTP 同步..."

yum install -y chrony || apt install -y chrony

systemctl enable chronyd

systemctl start chronyd

# 5. 防火墙配置(如有)

echo "🛡️ 配置防火墙端口..."

firewall-cmd --add-port=80/tcp --permanent 2>/dev/null

firewall-cmd --add-port=443/tcp --permanent 2>/dev/null

firewall-cmd --reload 2>/dev/null || echo "⛔ firewall-cmd not available, skipping..."

# 6. 部署边缘服务容器(示例为 Nginx-HLS)

echo "🚀 拉取并运行边缘容器服务..."

mkdir -p /data/hls

cat <<EOF > /data/hls/index.html

<html><body><h1>Edge Node Running</h1></body></html>

EOF

docker run -d --name edge-nginx \

-p 80:80 -p 443:443 \

-v /data/hls:/usr/share/nginx/html \

nginx:stable

# 7. 安装 Node.js 环境(可选)

echo "🔧 安装 Node.js..."

curl -fsSL https://deb.nodesource.com/setup_18.x | bash -

apt install -y nodejs || yum install -y nodejs

# 8. 展示部署信息

echo "✅ 部署完成!访问 http://<你的IP> 查看边缘服务状态。"

docker ps

使用说明

前提要求:

- 云主机已开放 80/443 端口(AWS 安全组、Naver ACL 配置)

- 建议使用 Ubuntu 20.04+ 或 Amazon Linux 2

执行方式:

chmod +x edge_deploy.sh

sudo ./edge_deploy.sh

扩展建议

- 可将服务容器换成你自己的 WebRTC、媒体服务器镜像,如 ant-media, ovenmediaengine, media-server-node 等;

- 可结合 Terraform 自动部署主机资源 + 运行该脚本;

- 可结合 Ansible 实现大规模批量边缘节点部署;