许多运维团队在香港部署服务器时,常常面临一个棘手问题:容器存储故障导致服务不可用,甚至造成数据丢失。本文将结合实际案例,深入探讨如何使用 Ceph 与 GlusterFS 这两种主流分布式存储方案,有效解决容器环境中的存储可靠性和扩展性问题。

一、香港容器服务器的存储瓶颈

在香港的IDC部署环境中,很多企业出于带宽、政策或地域策略,将Kubernetes集群或Docker Swarm容器部署在本地服务器。然而,这种部署模式常常采用本地磁盘或简单的NFS作为持久化存储:

- 单点故障严重:NFS服务中断会导致所有挂载的Pod读写失败。

- 扩展性受限:磁盘空间无法动态扩容,服务横向扩展受阻。

- 数据一致性差:缺乏冗余机制,写入失败可能导致数据丢失或不一致。

在这个典型案例中,香港金融服务客户部署了3台物理服务器构成的K8s集群,采用本地SSD作为存储卷挂载方式。一旦任意节点发生宕机,相关服务即刻中断,严重影响业务连续性。此类问题急需通过分布式存储解决。

二、Ceph:企业级分布式存储的首选方案

1. 核心架构

Ceph是一个统一的分布式存储系统,支持对象、块、文件三种存储方式,具有高可用性、强一致性和弹性扩展能力。核心组件包括:

- OSD(Object Storage Daemon):负责数据存储、复制和恢复。

- MON(Monitor):维护集群状态和元数据。

- MDS(Metadata Server):支持CephFS文件系统时使用。

- RADOS:Ceph底层的对象存储系统。

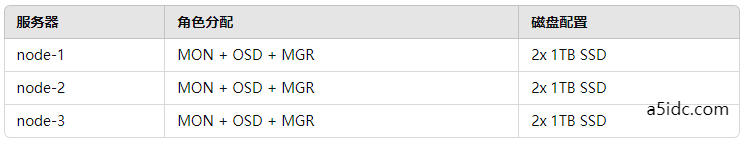

2. 典型部署架构

以3台服务器为例,可采用如下配置:

所有节点通过10Gbps局域网连接,使用cephadm自动部署。

3. 接入Kubernetes

使用Rook-Ceph作为Kubernetes中的操作层,自动管理Ceph集群资源:

apiVersion: ceph.rook.io/v1

kind: CephCluster

metadata:

name: rook-ceph

spec:

cephVersion:

image: ceph/ceph:v17.2.5

dataDirHostPath: /var/lib/rook

mon:

count: 3

storage:

useAllNodes: true

useAllDevices: true

之后通过 StorageClass 定义块存储:

apiVersion: storage.k8s.io/v1

kind: StorageClass

metadata:

name: ceph-block

provisioner: rook-ceph.rbd.csi.ceph.com

parameters:

pool: replicapool

imageFormat: "2"

imageFeatures: layering

实现Pod级别的动态持久化卷(PVC)分配和挂载。

4. 故障恢复与扩展优势

Ceph提供三副本或EC纠删码机制,任意节点故障不会影响数据访问。同时,新增节点后仅需扩展OSD,数据会自动重平衡。

三、GlusterFS:简洁灵活的文件级分布式存储方案

相较于Ceph,GlusterFS更加轻量,适用于对块存储要求不高但希望拥有多节点共享文件系统的应用场景。

1. 核心概念

- Brick:每个实际的数据卷。

- Volume:由多个Brick组成的逻辑存储单元。

- Translator:实现复制、分片、缓存等逻辑。

2. 构建高可用Volume

# 创建3个brick目录

mkdir -p /gluster/brick1 /gluster/brick2 /gluster/brick3

# 添加节点并创建volume

gluster peer probe node2

gluster peer probe node3

gluster volume create gv0 replica 3 \

node1:/gluster/brick1 \

node2:/gluster/brick2 \

node3:/gluster/brick3

gluster volume start gv0

这个配置可保证任一节点宕机时文件仍可读写。

3. 挂载与容器集成

可通过CSI Driver for GlusterFS接入Kubernetes,或通过hostPath方式在特定场景下直接挂载:

volumeMounts:

- name: gluster-storage

mountPath: /data

volumes:

- name: gluster-storage

persistentVolumeClaim:

claimName: gluster-pvc

4. 使用场景推荐

- 容器日志、配置文件、缓存数据共享

- 多副本同步、写密度低的场景

- 不需要块设备或Ceph那样复杂的操作逻辑

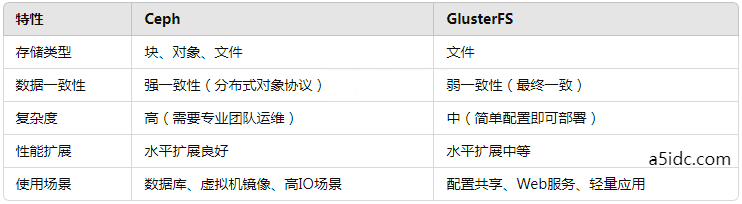

四、Ceph vs GlusterFS:技术选型建议

五、实操建议

在香港服务器容器部署环境中,为避免存储瓶颈带来的业务中断,企业应根据实际业务类型和技术团队能力选择合适的分布式存储方案:

- 对于核心系统、高并发数据处理场景,推荐使用Ceph,尽管初期运维成本较高,但长期更稳定可靠。

- 对于轻量级应用、文件共享型业务,使用GlusterFS可快速上线,具备一定的高可用能力。

- 此外,结合Prometheus进行存储监控、使用备份策略(如Velero)与S3同步存储副本,也是保障数据安全与业务连续性的重要组成部分。

我们部署分布式存储系统不仅仅是“装一个服务”,而是系统性工程,需要网络、磁盘、资源调度、自动化等方面的协同配合。未来,随着Kubernetes生态对存储标准的进一步完善,分布式存储将成为云原生架构中不可或缺的一环。