DeepSeek的AI 企业迅速崛起,凭借其自主研发的大规模模型DeepSeek-R1,已经在多项国际评测中表现出色。作为全类别大模型中排名第三的领先产品,DeepSeek-R1正受到国内外市场的广泛关注。本文将详细介绍如何从零开始进行 DeepSeek-R1 模型的微调与推理部署,帮助你掌握从基础到进阶的整个过程。

DeepSeek-R1是一个基于 Transformer 架构的大规模预训练模型,主要用于处理NLP任务,如文本生成、情感分析、机器翻译等。然而,预训练模型并不能直接适用于所有特定任务,因此通常需要进行微调来优化其在特定场景下的表现。本文将带领读者深入了解如何对 DeepSeek-R1 进行微调,并成功部署其推理服务。

一、准备工作

1. 环境搭建

在开始进行 DeepSeek-R1 微调和推理部署之前,我们需要准备合适的硬件和软件环境。推荐使用支持 CUDA 的 GPU 来加速训练和推理过程。

必要的硬件要求:

- GPU:NVIDIA Tesla A100、V100、T4 等高性能 GPU。

- 内存:至少 16GB(推荐 32GB 及以上)。

- 存储:至少 100GB 的存储空间,具体取决于模型大小和训练数据集。

必要的软件环境:

- 操作系统:推荐使用 Linux(如 Ubuntu 18.04 及以上版本)。

- Python:3.7 及以上版本。

- 深度学习框架:PyTorch 1.10 及以上版本。

- 依赖库:transformers、datasets、torch、numpy 等。

在安装相关依赖时,执行以下命令:

pip install torch transformers datasets numpy

2. 获取 DeepSeek-R1 模型

DeepSeek-R1 模型通常可以通过公开渠道下载,例如 Hugging Face 模型库。以下是加载 DeepSeek-R1 模型的 Python 代码:

from transformers import AutoModelForSequenceClassification, AutoTokenizer

model_name = "DeepSeek-r1"

model = AutoModelForSequenceClassification.from_pretrained(model_name)

tokenizer = AutoTokenizer.from_pretrained(model_name)

二、模型微调

1. 微调的基本概念

微调(Fine-tuning)指在已有的预训练模型基础上,通过少量标注数据重新训练,使模型适应特定任务。相较于从头开始训练,微调保留了预训练模型的大部分权重,仅针对最后几层进行调整,从而大幅度减少训练成本。

2. 数据准备

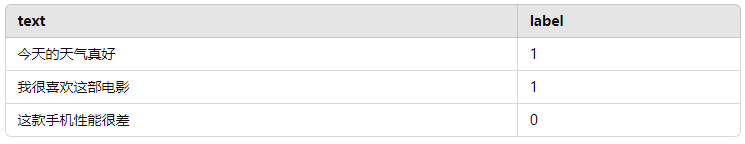

微调的关键在于数据集的选择和准备。以文本分类任务为例,假设我们有一个标注好的数据集,其格式如下:

可以使用 `datasets` 库加载数据集,如下:

from datasets import load_dataset

# 假设我们有一个CSV文件格式的数据集

dataset = load_dataset("csv", data_files={"train": "train.csv", "test": "test.csv"})

3. 数据预处理

为了让模型能够处理输入的文本数据,我们需要对数据进行分词处理。可以使用 `tokenizer` 对数据进行编码,确保输入符合模型要求:

def preprocess_function(examples):

return tokenizer(examples['text'], truncation=True, padding=True)

tokenized_datasets = dataset.map(preprocess_function, batched=True)

4. 微调模型

在微调过程中,我们需要选择合适的损失函数、优化器,并设置训练参数(如学习率、批次大小、训练轮数等)。使用 `Trainer` 类,可以简化训练过程。

from transformers import Trainer, TrainingArguments

training_args = TrainingArguments(

output_dir="./results", # 输出路径

evaluation_strategy="epoch", # 每个epoch结束后评估

learning_rate=2e-5, # 学习率

per_device_train_batch_size=16,# 训练时每设备的批次大小

per_device_eval_batch_size=64,# 评估时每设备的批次大小

num_train_epochs=3, # 训练轮数

weight_decay=0.01, # 权重衰减

)

trainer = Trainer(

model=model, # 微调的模型

args=training_args, # 训练参数

train_dataset=tokenized_datasets["train"], # 训练数据集

eval_dataset=tokenized_datasets["test"], # 测试数据集

)

trainer.train()

5. 保存微调后的模型

训练完成后,我们可以保存微调后的模型及其 tokenizer,供后续使用:

model.save_pretrained("./fine_tuned_model")

tokenizer.save_pretrained("./fine_tuned_model")

三、推理部署

1. 准备推理环境

在进行模型推理部署时,通常需要将模型加载到生产环境的服务器上。可以使用 Flask 或 FastAPI 等框架来提供 RESTful API 服务,也可以选择更高效的服务框架,如 TensorFlow Serving 或 TorchServe。

使用 Flask 部署:

首先,安装 Flask:

pip install flask

然后,创建一个 Flask 应用并加载微调后的模型:

from flask import Flask, request, jsonify

from transformers import AutoModelForSequenceClassification, AutoTokenizer

app = Flask(__name__)

# 加载微调后的模型

model = AutoModelForSequenceClassification.from_pretrained("./fine_tuned_model")

tokenizer = AutoTokenizer.from_pretrained("./fine_tuned_model")

@app.route("/predict", methods=["POST"])

def predict():

text = request.json["text"] # 从请求中获取文本数据

inputs = tokenizer(text, return_tensors="pt", padding=True, truncation=True)

outputs = model(**inputs)

prediction = outputs.logits.argmax(dim=-1).item() # 获取预测结果

return jsonify({"prediction": prediction})

if __name__ == "__main__":

app.run(debug=True)

2. 启动服务

使用以下命令启动 Flask 应用:

python app.py

此时,模型推理服务已经部署完成。可以通过 POST 请求发送文本,并获取预测结果。

3. 扩展性与优化

对于大规模的模型推理服务,我们可以考虑以下优化措施:

- 模型压缩:通过量化、剪枝等技术压缩模型,使其在生产环境中运行更高效。

- 多线程/多进程:在 Flask 或 FastAPI 中启用多线程或多进程,以处理更多并发请求。

- GPU 加速:如果使用 GPU 进行推理,可以显著提升模型的响应速度。

本文介绍了如何从零开始进行DeepSeek-R1大模型的微调与推理部署。从环境搭建、数据准备、模型微调到推理服务的部署,我们详细讲解了每一个步骤的技术实现。通过这些内容,读者不仅能够掌握大模型的微调技巧,还能学会将其部署到实际的生产环境中,为业务需求提供强大的 AI 支持。希望本文能够为你在 AI 项目的实际操作中提供有效的帮助与指导。