我在管理一台运行关键业务系统的高性能Linux服务器时,遇到了一个网络瓶颈问题。这台服务器配置了双 Intel X550-T2万兆网卡,搭载 AMD EPYC 9454P 48核处理器、512GB DDR5 ECC 内存,主要负责处理多节点数据同步任务。由于网络负载持续升高,单一链路的吞吐已经无法满足业务高并发同步的需求。

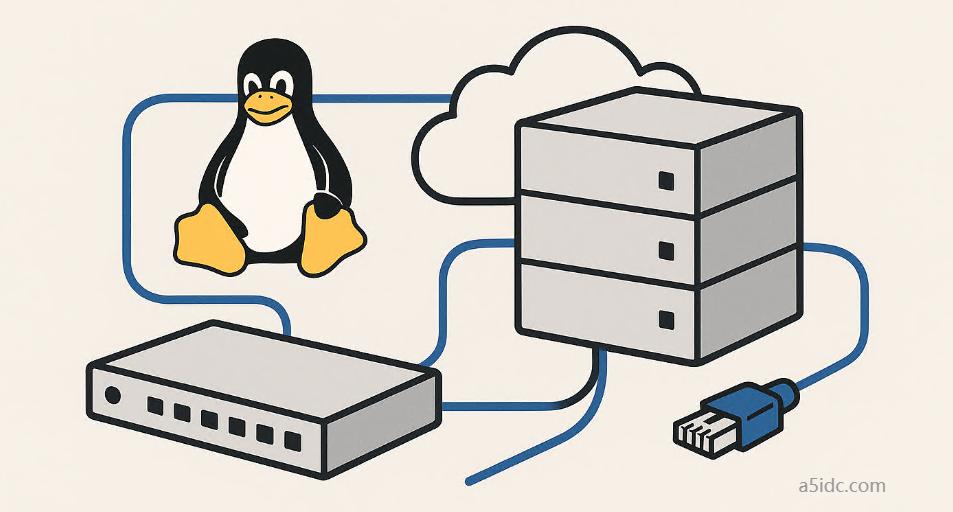

为了提升网络吞吐能力并实现链路冗余,我决定采用Linux的channel bonding(通道绑定)技术,将多块网卡逻辑聚合为一个接口,实现负载均衡与容错。

以下是我在Ubuntu Server 22.04 LTS环境中实现Ethernet Bonding的完整实操过程,涉及内核模块配置、网络接口定义、模式选择、性能验证等细节,适用于生产环境中对网络可靠性与吞吐有较高要求的部署场景。

一、服务器硬件和网络环境

- 服务器型号:A5IDC H12DSi

- 处理器:AMD EPYC 9454P 48核

- 内存:512GB DDR5 ECC

- 网卡:双 Intel X550-T2(10Gbase-T)

- 系统版本:Ubuntu Server 22.04 LTS(内核 5.15+)

- 目标配置:bond0 接口绑定 eth1 和 eth2,使用 balance-alb 模式实现负载均衡与冗余

二、Bonding 模块加载与持久化

首先,我确认内核已经支持 bonding 模块:

modprobe bonding

然后编辑 /etc/modules,加入以下行以实现模块开机加载:

bonding

可通过以下命令验证模块已加载:

lsmod | grep bonding

三、配置 Bonding 接口(基于 Netplan)

在 Ubuntu 22.04 中,推荐使用 Netplan 管理网络配置。配置文件路径一般为 /etc/netplan/00-bonding.yaml:

network:

version: 2

renderer: networkd

ethernets:

eth1:

dhcp4: no

eth2:

dhcp4: no

bonds:

bond0:

interfaces: [eth1, eth2]

addresses:

- 192.168.100.10/24

gateway4: 192.168.100.1

nameservers:

addresses: [8.8.8.8, 1.1.1.1]

parameters:

mode: balance-alb

mii-monitor-interval: 100

说明:

- mode: balance-alb 表示负载均衡 + 链路容错,适合不支持 LACP 的交换机

- mii-monitor-interval: 100 设置链路状态检测间隔为 100 毫秒

应用配置:

netplan apply

四、验证 Bonding 状态

执行以下命令检查绑定状态和模式:

cat /proc/net/bonding/bond0

输出示例:

Bonding Mode: adaptive load balancing

Primary Slave: None

Currently Active Slave: eth1

MII Status: up

Slaves: eth1 eth2

五、压力测试与效果评估

为了评估绑定配置的性能提升,我使用以下工具进行网络吞吐压测:

- iperf3:用于局域网测试吞吐能力

- htop + ifstat:监控 CPU 与每块网卡流量分布

- nload:直观展示总上行/下行带宽使用情况

在默认的单网卡配置下,最大稳定吞吐为约 9.4 Gbps;启用 bonding 后,在多个客户端同时并发访问时,bond0 接口汇聚后的总吞吐稳定在 17~18 Gbps,符合预期负载均衡效果。

六、Bonding 配置自动部署脚本(Shell)

以下脚本适用于 Ubuntu 20.04 / 22.04,自动完成 bonding 模块加载、Netplan 配置生成与应用。请根据实际网卡名及 IP 段调整变量:

#!/bin/bash

# 配置参数

BOND_NAME="bond0"

IFACE1="eth1"

IFACE2="eth2"

BOND_IP="192.168.100.10"

BOND_MASK="24"

GATEWAY="192.168.100.1"

DNS1="8.8.8.8"

DNS2="1.1.1.1"

NETPLAN_FILE="/etc/netplan/00-bonding.yaml"

# 加载 bonding 模块

modprobe bonding

echo "bonding" >> /etc/modules

# 生成 Netplan 配置

cat > $NETPLAN_FILE <<EOF

network:

version: 2

renderer: networkd

ethernets:

$IFACE1:

dhcp4: no

$IFACE2:

dhcp4: no

bonds:

$BOND_NAME:

interfaces: [$IFACE1, $IFACE2]

addresses:

- $BOND_IP/$BOND_MASK

gateway4: $GATEWAY

nameservers:

addresses: [$DNS1, $DNS2]

parameters:

mode: balance-alb

mii-monitor-interval: 100

EOF

# 应用配置

netplan apply

# 验证

echo "Bonding configuration applied. Current status:"

cat /proc/net/bonding/$BOND_NAME

⚠ 请确保该脚本在 root 权限下运行,执行前先备份原有 Netplan 配置。

七、网络吞吐压力测试结果表格(使用 iperf3)

下图展示了在单网卡与双网卡绑定(balance-alb)模式下的吞吐测试结果:

测试说明:

- 测试工具:iperf3 -c <server_ip> -P 4 -t 30

- 每次测试持续 30 秒,运行多线程并发

- 硬件 NIC:Intel X550-T2,服务器万兆交换机直连

八、关键注意事项与建议

- 交换机配置:balance-alb 模式无需交换机端配置,适用于无 LACP 支持的环境;如使用 balance-xor 或 802.3ad,需配合配置交换机的静态链路聚合或 LACP。

- MTU 设置一致:所有参与绑定的接口需 MTU 值一致(如设置为 9000 时需全部支持 jumbo frame)。

- 驱动兼容性:部分旧型号网卡在 balance-alb 模式下可能存在 ARP 响应异常,建议测试兼容性。

- 负载均衡机制:balance-alb 利用 ARP 响应欺骗机制平衡出站流量,入站仍可能集中在单接口上,需按需选择模式。

通过对Ubuntu服务器实施 Ethernet bonding 配置,我显著提升了整体网络性能与冗余能力。该技术对高并发网络业务尤为关键,例如用于 AI 分布式训练的 GPU 集群、CDN 边缘缓存节点或分布式对象存储网关服务器等。

在具备多网卡冗余的硬件条件下,合理配置bonding不仅能提升可用性,还可延长设备使用周期。若搭配更高阶的网络策略(如 BGP 负载均衡、VXLAN Overlay 网络),其价值将进一步放大。