凌晨两点,我还在办公室调试我们的实时交易系统。忽然,一条告警信息刷了屏——台湾IDC突发电力故障,整个站点的网络延迟飙升。我们虽在第一时间切换至新加坡的灾备节点,但几个旧模块切换过程略显迟滞,勉强维持服务不中断。等我走出机房,天已经微亮。

这次事件让我意识到,再高的可用性 SLA 承诺都敌不过现实中一根电缆、一场地震,或者一个人手误操作的致命影响。为此,我开始着手设计一套真正实用的“两地三中心”异地联动容灾方案,核心架构建立在台湾与新加坡两个主数据中心之上。本文将以实操的角度,拆解整个部署过程中我踩过的坑、选过的方案、调过的配置。

一、总体部署架构

核心目标:

主业务部署在台湾,灾备部署在新加坡;

- RTO ≤ 30 秒,RPO ≤ 5 分钟;

- 保证业务无状态节点自动切换,有状态服务(如数据库)数据一致性与自动同步;

- 实现分布式文件系统同步、DNS自动切换、数据库双活/热备。

网络与区域基础:

二、硬件基础配置

我们在两个节点均部署了以下核心设备:

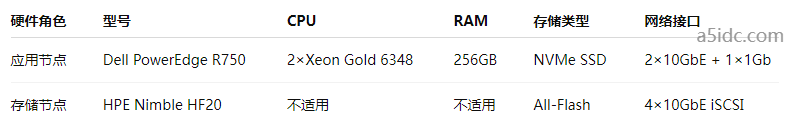

服务器配置(每地三台物理机 + 两台独立存储)

网络与连接:

- 两地间采用中立运营商 Megaport 提供 MPLS 专线,带宽 1Gbps;

- 外网出口均采用双ISP BGP互联,配置Anycast IP;

- 防火墙设备:Fortinet FortiGate 100F,提供虚拟隧道(IPSec)冗余方案。

三、部署技术栈与容灾机制实现

1️⃣ 应用层部署:Kubernetes 多集群联动

我们采用 K3s + Rancher 构建了双集群结构,台湾为主集群,新加坡为备用集群:

- 应用容器无状态,部署策略采用 Deployment + Horizontal Pod Autoscaler;

- 使用 Rancher Fleet 管理双集群应用一致性;

- 通过 ExternalDNS + CoreDNS 自动配置DNS记录;

- 加入 PodDisruptionBudget 限制异常驱逐,确保可控性。

灾备切换流程:

- Rancher 检测到主集群 Pod 状态异常;

- 自动触发备集群启用副本;

- ExternalDNS 5s 内更新 CNAME 指向;

- DNS TTL 设置为 15 秒,保证快速响应。

2️⃣ 数据库层:MySQL InnoDB Cluster + ProxySQL + GTID同步

- MySQL 8.0 InnoDB Cluster,在台湾部署主节点,新加坡为异步复制从节点;

- 使用 GTID(Global Transaction ID)保证数据一致性;

- ProxySQL 2.5 集成在两个区域,通过 hostgroup 实现读写分离;

- 关键数据表开启 ROW 级复制格式,避免语义不一致;

- 对接 Orchestrator 实现主从节点故障自动转移。

RPO 控制点:

- 异步复制延迟 < 5 秒,借助 SHOW SLAVE STATUS + 自定义 Prometheus Exporter 做秒级告警;

- WAL 日志写入对象存储(MinIO + EC),提升日志可重放效率。

3️⃣ 文件系统:Ceph + Rclone + Object Gateway 联动备份

- 我们采用 CephFS + Rclone 配置每夜增量同步:

- 主站点:CephFS 支持容器挂载路径;

- 每 5 分钟通过 Rclone Sync 推送至 S3 兼容对象存储(Backblaze B2);

- 灾难时,Rclone 拉取最新备份并挂载至 NFS 共享目录;

- 同步失败时发邮件 + Slack 通知。

四、关键问题排查与性能调优

在部署过程中遇到几个关键技术瓶颈:

延迟瓶颈:数据库同步超时

解决:手动调整 innodb_flush_log_at_trx_commit = 2,减轻写入负担;

启用 binlog group commit,配合压缩传输。

DNS更新延迟:

初期使用 Cloudflare DNS,发现全球同步不及时;

改用 AWS Route 53,支持健康检查+权重路由,更新实测 ≤ 10s。

跨区域 K3s 证书验证失败:

问题:K3s 节点之间通过 IP 验证 TLS,MPLS 不通公网IP;

解决方案:添加内网 SAN 证书签名 + kubelet 自定义 –tls-san 参数。

五、监控与自动化告警

监控技术栈:

- Prometheus + Grafana:实时监控数据库复制延迟、容器健康状态;

- Loki + Grafana:收集 Kubernetes 日志;

- Alertmanager:结合 Slack/Telegram 推送容灾告警。

自动化脚本:

- 使用 Ansible 编写集群恢复和数据同步脚本;

- Terraform 统一部署VPC、子网、路由与安全策略;

- Disaster Recovery Playbook 定期演练,包含模拟主站断电、网络隔离等场景。

六、技术落地,业务才能真正稳如磐石

这套“台湾-新加坡”容灾部署方案不是纸上谈兵,而是一次次事故、演练、优化打磨出的结果。它不完美,但已足够强壮,让我在面对故障时心中有数,手中有招。灾难不会通知你什么时候来,我们能做的,就是在平时打好每一根桩。