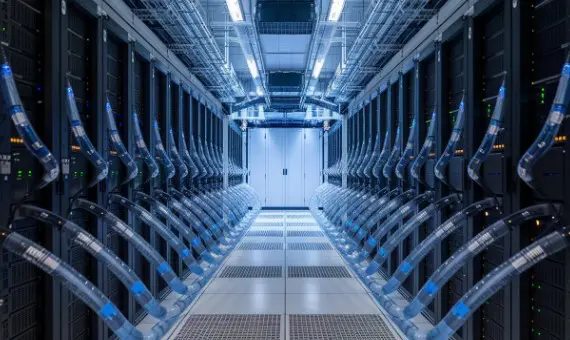

在快速发展的科技领域,数据中心正面临前所未有的挑战,必须有效管理日益强大的硬件产生的热量。人工智能(AI)工作负载的不断增加,传统冷却方法难以跟上这些变化。液冷技术应运而生,成为数据中心热管理的潜在创新者。本文将深入探讨液冷技术的复杂性及其在塑造AI驱动的数据中心未来中的重要性。

冷却技术的革新:液冷系统解析

液冷技术远不止于将服务器浸入水中。它是一种复杂的热管理方案,利用液体相较于空气的优越热传递特性。主要有两种液冷系统:

浸没式冷却:将服务器浸没在不导电的介电液体中。

直接芯片冷却:冷却液通过管道直接流向CPU和其他发热组件。

与传统空气冷却相比,液冷技术具有显著优势:

提升热传递效率

降低能源消耗

增强计算密度

降低噪音水平

提供热量回收的潜力

AI的热负荷:日益严峻的挑战

AI工作负载以其高计算需求著称。训练大型语言模型或进行复杂模拟可能会使硬件达到极限,产生大量热量。传统的空气冷却系统往往难以有效地散热,导致性能下降和能源成本上升。

为了说明AI工作负载的热量产生,请考虑以下模拟计算密集型任务的Python代码片段:

import numpy as np

import time

def ai_workload_simulation(size):

start_time = time.time()

# Generate large matrices

matrix_a = np.random.rand(size, size)

matrix_b = np.random.rand(size, size)

# Perform matrix multiplication (computationally intensive)

result = np.matmul(matrix_a, matrix_b)

end_time = time.time()

print(f"Time taken: {end_time - start_time:.2f} seconds")

# Simulate an AI workload

ai_workload_simulation(5000)

这个简单的例子展示了即使是基本的矩阵运算也可能在计算上非常昂贵,在过程中产生大量热量。

液冷技术:满足人工智能的需求

液冷技术通过多种方式应对AI工作负载带来的热挑战:

增强热散失:液体相比空气更有效地吸收和传递热量,从而更好地调控AI硬件的温度。

能源效率:液冷技术能够显著降低数据中心的能源使用效率(PUE),减少对高能耗空调的依赖。

提高计算密度:更有效的冷却使得服务器可以更紧密地排列,最大化数据中心的空间利用。

超频潜力:良好的热管理能够支持更高的时钟速度,提升AI性能而不损害硬件。

实际应用:液冷技术的实践

一些科技巨头已在其AI基础设施中采用了液冷技术。例如,谷歌在其TPU(张量处理单元)集群中引入液冷,显著提升了能源效率和计算密度。

微软也在尝试浸没式冷却,整台服务器浸入沸腾液体中以实现卓越的冷却效果。他们的两相浸没冷却系统在管理高密度AI工作负载方面取得了显著成效。

未来趋势:液冷技术与AI的结合

随着AI技术的发展,液冷技术也将不断演变。新兴趋势包括:

AI优化冷却:利用机器学习算法预测热量产生并实时优化冷却。

混合冷却系统:结合液冷与空气冷却,实现灵活高效的热管理。

边缘计算集成:为运行AI工作负载的小型分布式边缘计算节点适配液冷技术。

实施液冷技术:数据中心需要考虑的因素

尽管液冷技术带来众多优势,但数据中心运营商在实施前需考虑以下几个因素:

初始投资:与传统空气冷却系统相比,液冷系统通常需要更高的前期成本。

兼容性:现有基础设施可能需改造以适应液冷技术。

维护:员工可能需要专门培训以维护液冷设备。

可靠性:需采取适当的安全措施防止泄漏并确保系统的完整性。

随着AI不断推动计算的极限,液冷技术作为解决数据中心热挑战的有效方案逐渐受到关注。其高效的热管理能力、降低能耗以及提升计算密度的特性,使其成为AI驱动基础设施的理想选择。

虽然实施和初期投资方面仍存在挑战,但液冷技术的潜在优势不容小觑。随着技术的不断成熟与普及,我们预计它将在数据中心行业,尤其是在AI专注的设施中得到更广泛的应用。

数据中心的未来可能是由液冷技术的力量与人工智能对计算资源无止境渴求共同驱动的一场冷静革命。随着这些技术的共同发展,预计它们将重塑计算领域的格局,推动AI及其他领域可能性的边界。