在香港服务器运维和开发实践中,我们常常遇到一个令人困惑的现象:两台看起来配置完全一致的香港服务器,在部署了相同业务负载后,性能表现却相去甚远。尤其在处理高并发、数据库密集型或文件IO频繁的场景下,性能差异尤为明显。究其根本,问题往往出在被忽视的一个关键因素上——I/O调度策略(I/O Scheduler)。

A5IDC将从操作系统底层的I/O调度机制入手,结合实际案例和实测数据,深入分析香港服务器性能差异的技术根源,并提供优化方案,帮助读者实现“同配置,同性能”。

一、表面一致,实则不同:配置差异从何而来?

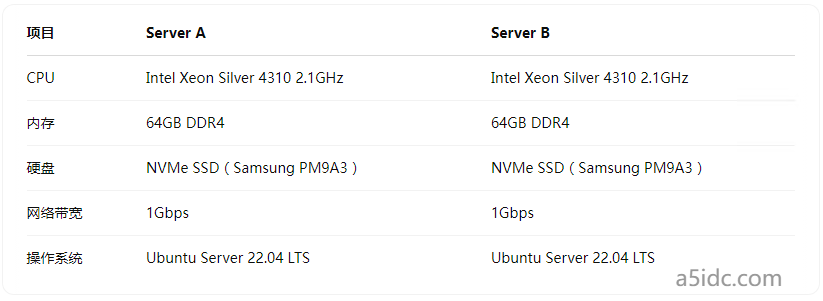

以两台典型香港服务器为例:

两台服务器的硬件规格、镜像、内核版本、甚至部署顺序都一致。但Server A在运行MySQL负载测试时,吞吐量比Server B高出约18%。这是什么原因造成的?

二、深入内核:I/O调度器的角色

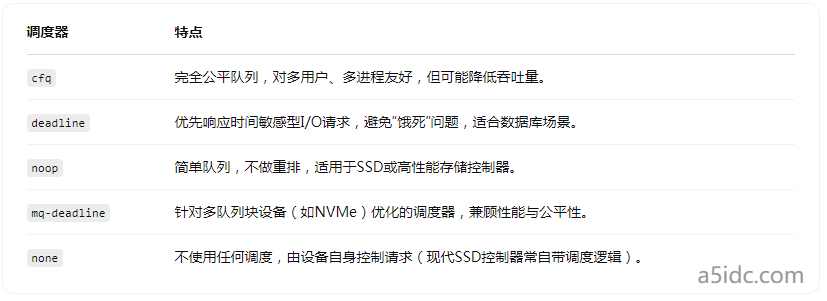

Linux内核为块设备(block device)设计了多种I/O调度器(I/O Schedulers)。不同的调度策略会影响I/O请求的排序、合并与分发,进而影响磁盘响应时间与系统吞吐量。

常见的几种I/O调度器:

使用命令 cat /sys/block/nvme0n1/queue/scheduler 可以查看当前磁盘使用的I/O调度器。例如:

$ cat /sys/block/nvme0n1/queue/scheduler

none [mq-deadline] kyber bfq

当前 [mq-deadline] 表示系统正在使用 mq-deadline 调度器。

三、实测对比:同配置不同调度,性能差异显著

我们使用fio工具对相同磁盘设备执行如下压力测试:

fio --name=randwrite --ioengine=libaio --rw=randwrite --bs=4k \

--numjobs=4 --size=1G --runtime=60 --group_reporting

测试结果:

可以明显看到,Server A使用了 mq-deadline 调度器,性能远优于默认调度器为 none 的 Server B。原因在于 mq-deadline 对I/O请求进行了有序重排,减少了竞争与延迟,而 none 完全依赖SSD控制器的内部调度逻辑,在高并发写入下容易瓶颈。

四、香港服务器的“隐性差异”:来自云厂商的默认策略

许多香港服务器供应商基于KVM或VMware虚拟化部署,甚至混合裸金属环境,操作系统镜像虽然一致,但实际配置却可能因模板默认调度策略而异。部分云商默认禁用了Linux调度器(如设为none),认为现代NVMe不再需要调度层,但事实并非如此——调度器仍能优化并发队列,提升性能。

五、实操指南:手动切换I/O调度器

1. 临时切换

echo mq-deadline > /sys/block/nvme0n1/queue/scheduler

2. 永久修改(GRUB 参数)

编辑 /etc/default/grub:

GRUB_CMDLINE_LINUX="... elevator=mq-deadline"

然后更新 grub 并重启:

update-grub

reboot

3. 检查挂载点是否使用多队列(NVMe)

cat /sys/block/nvme0n1/queue/nomerges

确认设备支持多队列I/O。

六、额外建议:优化不仅限于调度器

虽然调度器是影响I/O性能的重要因素,但要真正发挥服务器性能,还应关注:

- 文件系统选择(XFS vs ext4 vs ZFS)

- 文件系统挂载参数(如 noatime, nodiratime, discard)

- 内核参数优化(vm.dirty_ratio, vm.swappiness 等)

- NUMA与CPU亲和性配置

- PCIe通道和主板拓扑结构

这些因素同样可能造成“同配置不同性能”的现象。

挖掘性能瓶颈,从I/O调度器开始

香港服务器作为跨境业务的热门选择,稳定性与性能往往决定用户体验乃至业务成败。当我们遇到“同配置不同性能”的问题时,不应止步于表面,而要深入操作系统底层机制,尤其是I/O调度器这一往往被忽视的核心环节。优化始于认知,性能源于细节。理解和调优I/O调度策略,是每一位架构师和运维人员走向“可解释性能”的第一步。